Mekanismene vi bruker til innlogging i dag gjør livet på nett krevende.

Mange passord å holde styr på er en daglig utfordring. Folk forenkler gjerne ved å bruke det samme over alt, eller ved å skrive ned. Begge deler går ut over sikkerheten.

Problemet vokser i takt med økningen i antall tjenester som krever innlogging med passord.

For mennesker med hukommelsesproblemer eller lese- og skrivevansker er det enda verre. For ikke å snakke om for de som sliter med synet.

Noen løsninger gjør det helt umulig for personer med funksjonshemminger å logge seg på.

– Myndighetene må ta tak

Norske og internasjonale forskningsgrupper har forsøkt å finne løsninger som kan gjøre innlogging brukbart for alle, men ingen av dem har hatt gjennomslag.

– Dette er et overordnet problem. Myndighetene må ta tak om det skal bli gjort noe medsier Kristin Skeide Fuglerud, sjefsforsker ved Norsk regnesentral (NR).

– Enkeltaktører kan ikke løse dette alene.

Skeide Fuglerud mener at innlogging er nåløyet for å få brukt IKT, og helt fundamentalt for å delta i informasjonssamfunnet.

Hun har det norske forskningsprosjektet e-Me – Inkluderende identitetsforvaltning som en case i sin doktorgrad.

Mangfold er en utfordring for de som jobber med universell utforming, og det er dette Skeide Fuglerud forsker på. Innen design finnes et mantra om at du skal kjenne brukeren din. Men når du skal lage noe som skal passe for alle, hvordan er det mulig?

– Det er en veldig stor utfordring å lage universelt utformede løsninger. Når de skal være fleksible for å kunne brukes av alle, blir det ofte mer sammensatt også, sier forskeren.

– Hvis man legger inn flere valg, blir det mer funksjonalitet, mindre brukervennlig og mindre universelt utformet. Da får vi en ond sirkel

Flere kanaler for innlogging

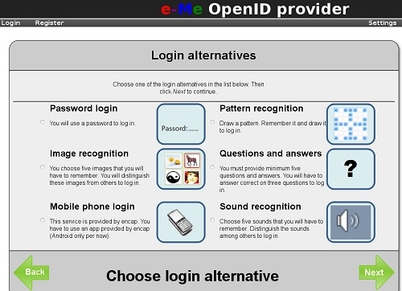

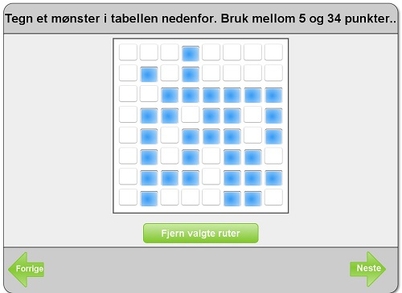

I e-Me har forskerne utviklet en alternativ løsning for identifikasjon på nettet, hvor brukeren kan velge mellom å logge inn med bilder, lyd, mønster, spørsmål/svar, vanlig passord eller autentisering i to kanaler med mobil og pinkode.

– Man kan gjøre dette på veldig mange ulike måter hvis man vil, sier Riitta Hellman, leder for e-Me-prosjektet og seniorrådgiver i selskapet Karde, hvor hun jobber med tilgjengelighet og teknologiske hjelpemidler for personer med kognitive utfordringer.

Prosjektet inkluderte ikke biometri, for eksempel gjenkjenning av fingeravtrykk, iris eller stemme.

– Det vide spekteret av muligheter burde brukes mer for mennesker med spesielle utfordringer, sier Hellman.

Forskerne har funnet ut at nærmere halvparten av alle brukerhenvendelser til Altinn handler om innloggings- og passordproblemer, så her er det ikke bare de med funksjonshemminger som sliter.

– Vi uten funksjonsnedsettelser finner måter å håndtere dette på. Mange med funksjonsnedsettelser har ikke den muligheten. Første bud må være å gjøre det mulig for dem å komme inn, sier Skeide Fuglerud.

– Når det er så vanskelig for folk flest, er det opplagt at det finnes mennesker med funksjonshemminger som ikke mestrer dette i det hele tatt, sier Hellman.

Andre typer innlogging enn tekst og tall som skrives inn er teknisk mulig og sikkert, og det er mange som har behov for det, konkluderer forskerne.

De ser for seg at det går an å opprette en profil for hver person som for eksempel lagres i nettskyen. Den kan fortelle hvilken type innlogging personen foretrekker.

Tjenester på nettet kan deretter koble seg opp mot denne profildatabasen. Ideen er å unngå at brukerne bli konfrontert med de samme problemene hver gang de er i kontakt med et nytt system.

– Ikke spredd om seg

Løsningen som ble utviklet bygger på teknologien OpenID, og kan benyttes til ulike tjenester om man legger til rette for det. Den ble testet på en brukergruppe med synsnedsettelser.

I utlandet finnes det også andre, store prosjekter som har sett på de samme problemstillingene – for eksempel det store initiativet Global Public Inclusive Infrastructure (GPII).

Dette går også ut på å lage en global infrastruktur hvor mennesker kan ha en profil i skyen eller et annet sted, som brukes når de skal logge på en tjeneste.

Da vil tjenesten kunne tilpasse seg folks behov, enten de er fargeblinde eller trenger større skriftstørrelse.

– GPII har pågått i mange år, men ennå har ikke dette spredd om seg. Det siste jeg hørte var at man ikke i tilstrekkelig grad har tatt inn over seg utfordringene for å få dette til, som finnes på alle samfunnsplan – økonomisk, sosialt, kulturelt og teknologisk, sier Skeide Fuglerud.

Til sommeren trer Diskriminerings- og tilgjengelighetsloven i kraft på IKT-området. Den handler om at ingen skal utestenges på grunn av nedsatt funksjonsevne.

Alle nye tjenester som retter seg mot allmennheten – offentlige eller private – må oppfylle et bestemt sett med kriterier som finnes i retningslinjene Web Content Accessibility Guidelines (WCAG), utviklet av World Wide Web Consortium.

Sikkerhet

– Problemet er at denne standarden sier lite om problemstillingene knyttet til innlogging, og dreier seg om det som møter deg etter at du har kommet deg inn, sier Skeide Fuglerud.

Hun mener prosjektet e-Me illustrerer hvordan det kan gå an å løse problemet, men at det er mange politiske og økonomiske utfordringer.

Sikkerhet er et viktig stikkord.

– Vil man ha alle brukernavn og passord på samme sted? Mange er skeptiske til å legge igjen sin innloggingsinformasjon på ett sted – det kan innebære å gi én aktør for mye makt. Hvem skulle eventuelt eie og drifte det? Vil man kunne stole på den aktøren? En slik aktør, som lagrer din tilgang til mange tjenester, kan også bli mer utsatt for angrep, sier Skeide Fuglerud.

Hun tror det er et spørsmål om å finne en balanse for vanlige brukere. Kanskje vil vi ikke putte de viktigste tjenestene inn i en slik felles innlogging, mens det vil være ok å legge inn de mindre viktige.

– Da kan vi kanskje redusere antall brukere til noen få, sier Skeide Fuglerud.

Seniorforsker Lothar Fritsch ved NR var med i e-Me-prosjektet som sikkerhetsekspert, og mener de ulike løsningene har noen begrensninger.

– For eksempel kan lydbasert identifisering, hvor brukeren velger en sekvens av melodier, bare brukes trygt når brukeren sitter med hodetelefon, så ingen andre kan høre passordet, sier han.

– Det er intuitivt opplagt at jo flere systemer du smelter sammen, jo større risiko bærer du. Men i dag har vi muligheter til så høy sikkerhet, at det ikke er noe argument mot å lage inkluderende løsninger, sier Hellman.

– Bør være forberedt

Det koker uansett ned til at man ikke kan basere seg på kun én innloggingsmetode.

Fritsch mener de ulike utformingene av alternative innloggingsmekanismer bør undersøkes videre, slik at det utvikles trygge måter å bruke dem på.

– Tjenester på nett bør være forberedt på at de må tilby flere identifikasjonskanaler for folk med ulike behov. Det vil lønne seg på sikt når de kan flytte kundene over til metoder som passer bedre til endret livssituasjon, sier Fritsch.

For eksempel når folk blir eldre og ser dårligere.

Løsningen med færrest mulige og sikre alternativer for å dekke alle verdens brukere har man ikke funnet enda.

– Selv om man bruker biometri må det være alternativer, for det er ikke alle som har fingre eller øyne uskadet hele livet, sier Fritsch.

Når personlig tilpasning av tjenester krever informasjon om den enkelte – for eksempel i en brukerprofil, kommer dessuten problemet med at også det å ha en brukerprofil krever innlogging.

For hvordan kan en innloggingstjeneste vite at du trenger bildeinnlogging uten å vite hvem du er?

– Her er det uvisst hvor nærme man er en løsning, for dette har vist seg vanskelig i store, internasjonale forskningsinitiativer, sier Skeide Fuglerud.

– I e-Me-prosjektet måtte man velge mellom de fem alternativene for innlogging hver gang man skulle logge på tjenesten. Det er ikke så gunstig. På den andre siden vet du kanskje at du alltid bruker tredje alternativ, så belastningen kan bli mindre om dette ble brukt til innlogging alle steder, sier Skeide Fuglerud.

Brukerinvolvering

Fordelen er at du alltid bruker den samme innloggingen, og at resten av tjenesten kan være tilpasset din brukerprofil.

Selv om prototypen foreligger, tror Skeide Fuglerud at vi må dra med oss haugen med brukernavn og passord i enda noen år framover.

Det tar tid å bytte ut slike ting, og lovverket trer først i kraft for nye løsninger, mens etablerte tjenester har til 2021 å forbedre seg.

Skeide Fuglerud har jobbet med universell utforming av IKT i ulike sammenhenger i 10 år, og i doktorgraden jobber hun blant annet med prinsipper for å redusere kompleksitet.

Hun har også vært leder for komiteen som utviklet en standard for brukermedvirkning og universell utforming av IKT for Standard Norge, lansert i desember.

– Innen forskning og praksis på feltet brukskvalitet, er beste praksis brukerinvolvering og brukertesting. Det finnes ikke seriøse aktører som lager IKT-produkter i dag uten brukertesting som del av utviklingsprosessen, sier Skeide Fuglerud.

– Diskriminerings- og tilgjengelighetsloven krever at man skal følge retningslinjer, men man kommer ikke i mål kun med det. Man må involvere folk med funksjonsnedsettelser for å lage gode tjenester. Loven burde hatt med noe om brukermedvirkning.